一文看懂LLM推理,UCL汪军教授解读OpenAI ο1的相关方法

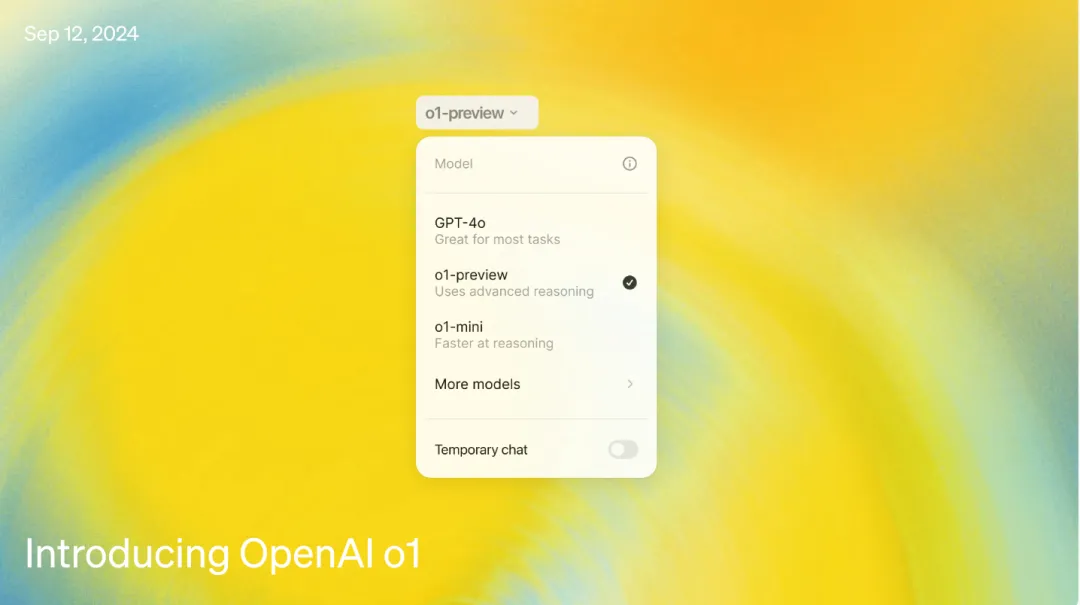

一文看懂LLM推理,UCL汪军教授解读OpenAI ο1的相关方法OpenAI 最近发布的 o1 系列模型堪称迈向强人工智能的一次飞跃,其强大的推理能力为我们描绘出了下一代人工智能模型的未来图景。近日,伦敦大学学院(UCL)人工智能中心汪军教授撰写了一份「LLM 推理教程」,深入详细地介绍了 OpenAI ο1 模型背后的相关方法。

OpenAI 最近发布的 o1 系列模型堪称迈向强人工智能的一次飞跃,其强大的推理能力为我们描绘出了下一代人工智能模型的未来图景。近日,伦敦大学学院(UCL)人工智能中心汪军教授撰写了一份「LLM 推理教程」,深入详细地介绍了 OpenAI ο1 模型背后的相关方法。

随着大规模语言模型的快速发展,如 GPT、Claude 等,LLM 通过预训练海量的文本数据展现了惊人的语言生成能力。然而,即便如此,LLM 仍然存在生成不当或偏离预期的结果。这种现象在推理过程中尤为突出,常常导致不准确、不符合语境或不合伦理的回答。为了解决这一问题,学术界和工业界提出了一系列对齐(Alignment)技术,旨在优化模型的输出,使其更加符合人类的价值观和期望。

Consensus 是一个 AI 驱动的学术搜索引擎,专注于从经过同行评审的科学文献中提炼和总结洞见。利用 LLM 和向量搜索的方式提取 2 亿篇文献中的核心共识,提供更精准的搜索结果。

大语言模型(Large Language Models, LLMs)的强大能力推动了 LLM Agent 的迅速发展。围绕增强 LLM Agent 的能力,近期相关研究提出了若干关键组件或工作流。然而,如何将核心要素集成到一个统一的框架中,能够进行端到端优化,仍然是一个亟待解决的问题。

近日,机器学习研究员、畅销书《Python 机器学习》作者 Sebastian Raschka 又分享了一篇长文,主题为《从头开始构建一个 GPT 风格的 LLM 分类器》。

科学技术的快速发展过程中,机器学习研究作为创新的核心驱动力,面临着实验过程复杂、耗时且易出错,研究进展缓慢以及对专门知识需求高的挑战。近年来,LLM 在生成文本和代码方面展现出了强大的能力,为科学研究带来了前所未有的可能性。然而,如何系统化地利用这些模型来加速机器学习研究仍然是一个有待解决的问题。

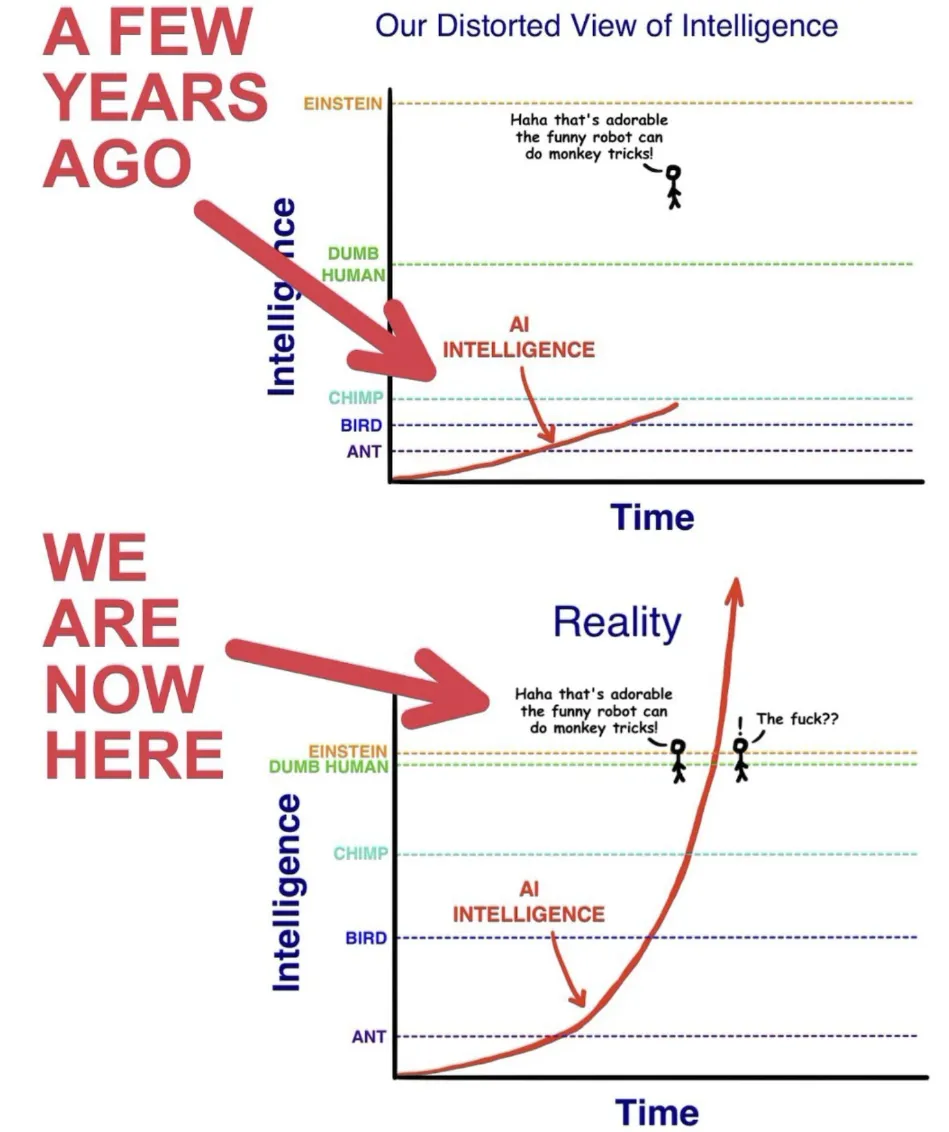

Self-play RL 开启 AGI 下半场

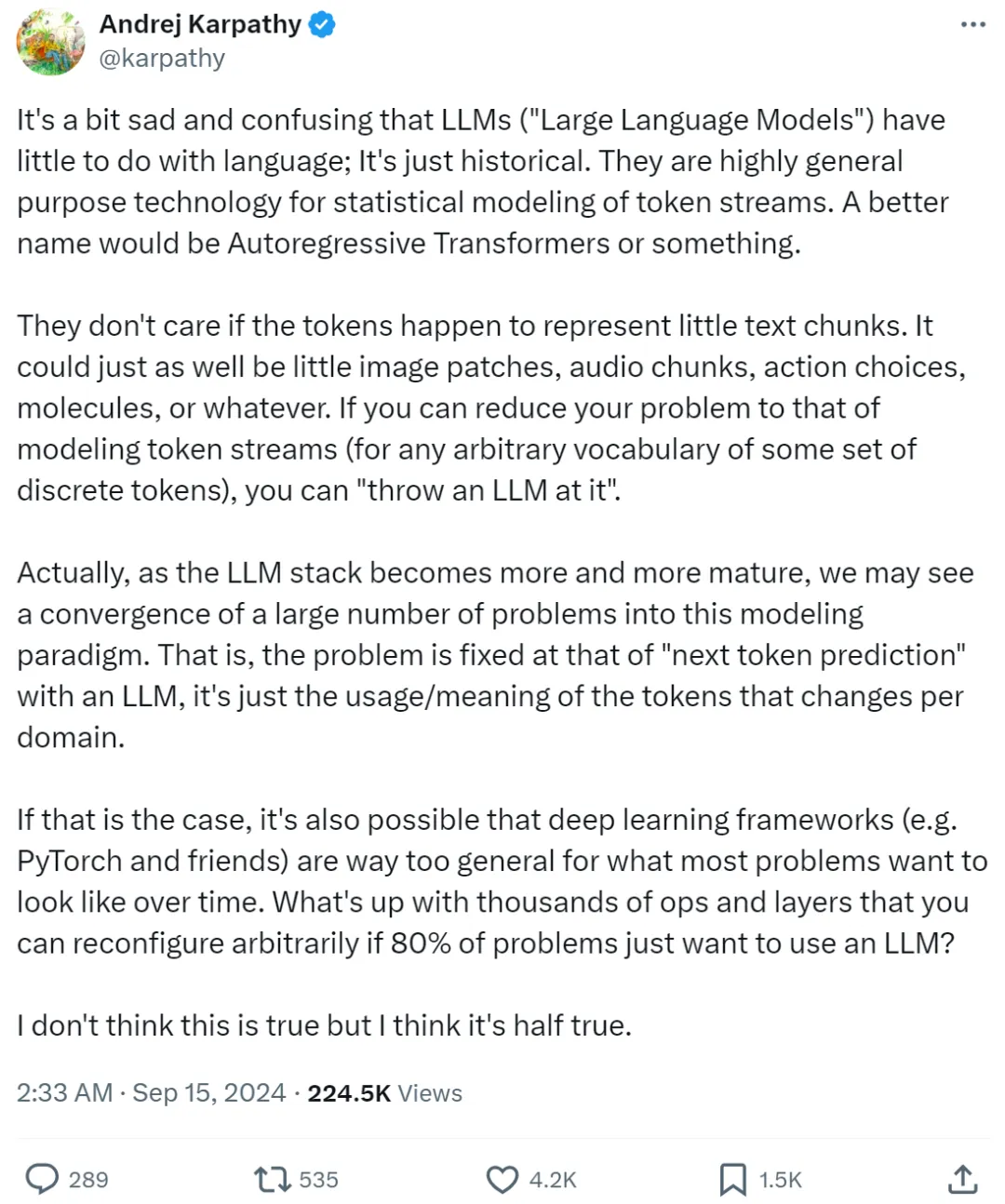

LLM 应该改名吗?你怎么看。

近段时间,AI 编程工具 Cursor 的风头可说是一时无两,其表现卓越、性能强大。近日,Cursor 一位重要研究者参与的一篇相关论文发布了,其中提出了一种方法,可通过搜索自然语言的规划来提升 Claude 3.5 Sonnet 等 LLM 的代码生成能力。

近日,一篇关于自动化 AI 研究的论文引爆了社交网络,原因是该论文得出了一个让很多人都倍感惊讶的结论:LLM 生成的想法比专家级人类研究者给出的想法更加新颖!